Cara Setting Robots.txt di Blogspot dengan Mudah

Pengaturan robot.txt dan tag tajuk robot khusus di Blogger - Setiap pemilik blog atau website pastinya menginginkan blog yang dibuat berada pada peringkat atas pencarian Google. Tapi, mesin pencari Google tidak bisa membedakan halaman mana yang boleh dan tidak boleh diindeks. Agar halaman setiap blog bisa terindeks dengan rapih dan membatasi halaman yang tidak boleh diindeks, kalian membutuhkan file robots.txt. Apa itu robot.txt dan bagaimana cara setting robot.txt di Blogger? Simak ulasannya dibawah ini.

Sebelum itu, perlu diketahui bahwa dengan memberikan robot.txt pada blog, maka akan memberikan tanda ke Google ke mana saja akses yang harus dilakukan dan halaman mana saja yang perlu diindeks.

Selain itu, robot.txt juga berguna untuk SEO, dimana setiap artikel yang ada di blog kita akan semakin mudah dan lebih cepat untuk diindeks oleh mesin pencari Google. Tujuannya adalah untuk menaikan peringkat situs di Search Engine Result Pages atau SERP dan proses indexing lebih terstruktur.

Apa itu Robots.txt

Robot.txt merupakan sebuah file yang menyediakan sekumpulan instruksi untuk mesin pencari atau menunjukkan jalan kepada mesin pencari. Istilah mudahnya adalah sebagai jalan atau tanda yang digunakan blog atau website untuk menunjukkan jalan kepada mesin pencari.

Ketika membuat blog baru dan dihubungkan dengan Google Search Console maka setiap halaman blog akan di crawl oleh Google dan muncul di hasil penelusuran. Google akan melakukan pendataan sesuai dengan kata kunci yang ada pada situs dan lain sebagainya.

Robot.txt bertugas untuk memisahkan halaman yang tidak ingin kalian tampilkan ke dalam mesin pencari Google. Dikarenakan meskipun tidak ada file ini Google tetap akan melakukan proses perayapan sampai dengan kseluruhan halaman yang ada di blog kalian.

Selain itu, robot.txt juga bertugas untuk menghalangi beberapa situs pencari agar tidak melakukan perayapan blog. Hal ini ditujuan untuk mengurangi beban yang harus di terima oleh blog.

Jadi pada intinya, robot.txt membantu mesin pencari Google untuk memilih halaman situs mana saja yang akan ditampilkan pada mesin pencari Google. Pengguna juga bisa menyesuaikan halaman yang boleh dan tidaknya untuk ditampilkan di mesin penelusur.

1. Cara Setting Robots.txt Khusus di Blogger Agar SEO Friendly

Untuk blog atau website yang memuat beberapa file atau informasi yang dianggap penting yang tidak boleh dirayapi atau tidak dirayapi maka menggunakan robots.txt khusus adalah hal yang tepat, tetapi dengan format yang sesuai dengan aturan pada Google Search Console. Untuk penerapannya pada Blogger silahkan simak caranya dibawah ini.

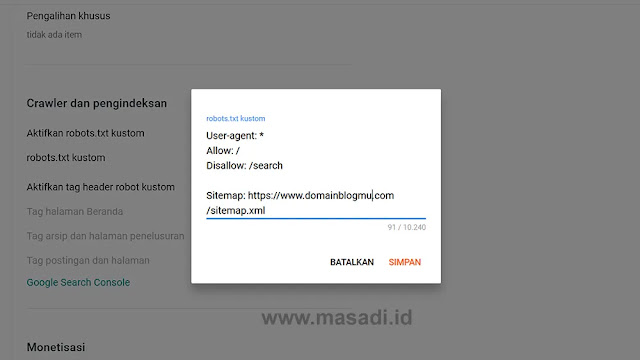

Setting Robots.txt Khusus Blogger

1. Pertama buka menu Setelan pada dashboard Blogger

2. Lalu cari bagian Crawler dan Pengindeksan

3. Aktifkan robots.txt custom, lalu masukan settingan robots.txt yang aman seperti dibawah ini.

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://www.domainblogmu.com/sitemap.xml

Catatan : Ganti yang berwarna merah dengan link domain blog kalian

4. Setelah selesai klik tombol Simpan

Mencegah Perayapan pada URL Halaman tertentu

Nah, jika ada halaman khusus yang tidak ingin dirayapi, kalian tinggal menambahkannya pada Disallow. Contohnya seperti dibawah ini:

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Disallow: /p/about.html

Disallow: /2021/10/cara-cepat-dapat-duit.html

Allow: /

Sitemap: https://www.domainblogmu.com/sitemap.xml

Untuk mengecek apakah robots.txt sudah berubah dan sama dengan settingan diatas, buka URL berikut : https://www.domainblogmu.com/robots.txt

Istilah pada file Robots.txt

- User-agent artinya bot atau mesin pencari ynag boleh merayapi blog atau website, misalnya Googlebot, Bingbot, Yahoobot dan bot-bot lainnya

- Disallow artinya mesin bot dilarang untuk mengcrawl atau merayapi

- Allow artinya mesin bot diperbolehkan atau diijinkan untuk mengcrawl atau merayapi

- Sitemap artinya sitemap yang digunakan pada blog atua website kalian

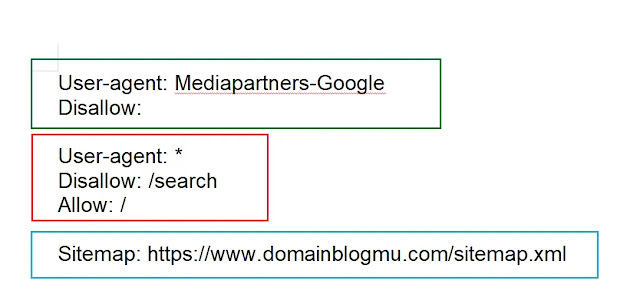

Arti Pengaturan pada robots.txt khusus pada Blogger

User-agent : Mediapartners-Google artinya Mesin bot yang diijinkan atau boleh merayapi adalah Media Parter Google. Pengaturan ini sangat penting jika wesite kalian telah didaftarkan pada google adsense.

Disallow : artinya Dilarang merayapi dengan nilai kosong, maksudnya bahwa google diijinkan untuk merayapi semua website atau blog.

Arti keseluruhan Mediapartners Google diijinkan atau diperbolehkan untuk mengcrawl atau merayapi semua isi blog atau web.

User agent : * artinya semua bot diijinkan atau dibolehkan untuk merayapi blog atau web (yang ditandai dengan *).

Disallow : /search artinya semua bot tidak diibolehkan untuk merayapi semua nilai search atau pencarian di blog atau web.

Allow : / artinya semua mesin bot dibolehkan untuk merayapi web atau blog.

Arti keselurahan aturan robot txt ini adalah semua bot diijinkan atau diperbolehkan untuk mengcrawl atau merayapi blog atau web kecuali pada bagian search atau pencarian.

Sitemap : https://domainblogmu.com/sitemap.xml artinya sitemap yang digunakan pada blog atau website kalian.

Kemungkinan yang terjadi saat menggunakan file Robots.txt

Pada saat kalian menggunakan settingan robot txt pada blogger maka ada kemungkinan muncul laporan pada cakupan yang berkenaan dengan hal berikut ini:

Diindeks - Meski diblokir oleh Robots.txt

Biasanya notifikasi tersebut muncul karena adanya perintah larangan untuk mengindeks URL halaman Label sehingga muncul pesan seperti ini yang berupa saran penyempurnaan agar googlebot dapat merayapi semua halaman blog atau website tanpa menggunakan larangan Disallow : /

Diblokir oleh

Pada laporan ini memberi isy Robot.txtarat bahwa halaman atau URL ini telah diblokir karena perintah larangan tidak boleh diindeks dengan Disallow atau Noindex.

Pertimbangan yang mendasar agar halaman tidak diindeks adalah merupakan pertimbangan kalian sendiri akan tetapi memblokir googlebot akan mempersulit pengambilan halaman artikel sehingga akan berpengaruh terhadap URL lainnya yang mengarah ke URL tersebut.

2. Mengatur Custom Robots Header Tags di Blogger

Setelah kalian selesai membuat custom robots.txt seperti diatas, selanjutnya kalian setting pada tag robot header custom. Masih di menu ynag sama pada menu setelan > Crawler dan Pengindeksan. Pada bagian Aktifkan Tag Header Robot Custom kalian akitfkan atau Enable. Lalu samakan pengaturannya dengan gambar dibawah ini.

Tag Halaman Beranda

Tag Arsip dan Halaman Penelusuran

Tag postingan dan halaman

Keterangan:

1. Mengizinkan mesin pencari untuk merayapi semua direktori homepage/beranda, post dan pages/halaman statis.

2. Tidak mengizinkan mesin pencari untuk merayapi direktori artchive/arsip dan search/pencarian seperti yang sudah dijelaskan diatas.

3. Kenapa Direktori Archive/Arsip dan Search/Pencarian tidak dirayapi?

Karena direktori kedua halaman itu mengandung URL ynag depannya sama. Sudah dicntohkan diatas, direktori hasil pencarian adalah sebagai berikut:

https://www.domainblogmu.com/search?q=cara+cepat+dapat+duit

https://www.domainblogmu.com/search/label/gadget

https://www.domainblogmu.com/search?update-max=2021-01-30242%64FSRmax-result=8#pageNo=6

dan masih banyak lagi sesuai dengan jumlah artikel yang ada di blog kalian

Format penulisan URL setelah homepage https://www.domainblogmu.com selalu sama, yaitu diikuti oleh /search. Melarang robot merayapi direktori ini bertujuan untuk mencegah konten duplikat yang bisa berakibat terkena penalti dari mesin pencari.

Penutup

Demikianlah cara menggunakan robot txt dan beberapa istilah pengertiannya dengan benar agar artikel tetap terindeks dan tidak salah dalam memasukan robots txt kustom. Semoga bermanfaat dan mohon maaf jika ada kesalahan. Saya bukan ahli SEO jadi jika ada yang salah mohon koreksinya, cara tersebut adalah cara yang biasa saya gunakan pada blog-blog yang saya buat.